更新时间:2025-04-02来源:网络

研究背景

当前科技发展迅猛,人工智能的性能测试成为了焦点。上周,加州圣地亚哥分校的Hao人工智能实验室选择了《超级马力欧兄弟》这款经典游戏,用它来测试AI的能力。过去,游戏一直是评估AI成就的工具,这次用马力欧游戏来测试,有助于我们更全面地了解AI的表现。

实验室长期专注于AI领域的深入研究,这次他们别具一格地挑选了游戏作为实验平台,意在在新的环境中挖掘AI的潜能。这一研究有望为AI的未来发展带来新的洞见和思路。

测试方法

这次测试并未采用1985年发布的《超级马力欧兄弟》的原始版本。游戏是在模拟器上运行的,并且通过一个我们自主研发的框架与人工智能系统相连。这个框架使得AI能够操控马力欧。此外,实验室还向AI输出了基础操作指令,例如“注意前方有障碍或敌人,请向左移动或跳跃以避开”,并且还提供了游戏截图。

AI能够以代码形式控制马力欧。这一过程犹如为AI安排了一场“考试”,目的是观察其在游戏环境中的问题解决能力。借助严格的测试手段,实验室得以准确评估每个AI模型在游戏中的实际表现。

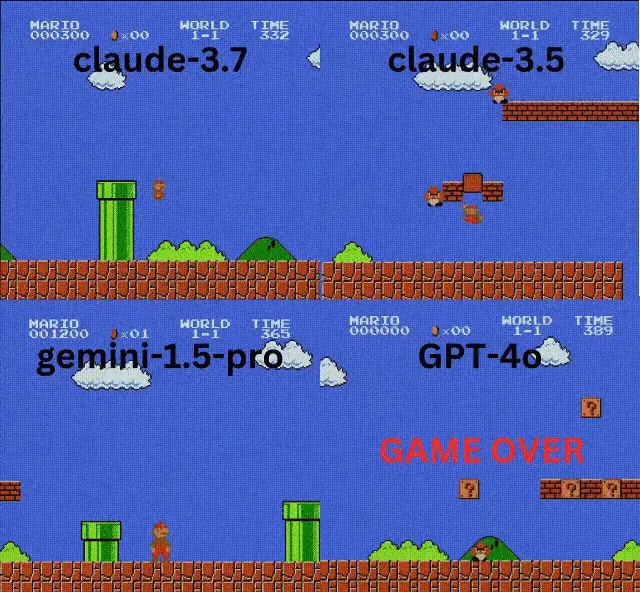

模型表现

在参与测试的AI模型里,3.7的表现最为出色。它能够迅速作出反应,规划出行路径,游戏操作显得很流畅。排在第二位的是3.5,同样显示了不错的游戏技巧,能够在复杂环境中灵活应对。

相较之下,谷歌的1.5 Pro和GPT-4o的表现不尽理想。它们在应对游戏中的各种情形时,反应迟缓,操作不够精确,因而游戏进程和得分都不太令人满意。

推理与非推理模型差异

在实验中,我们发现o1这类推理模型的表现并不如“非推理”模型。通常情况下,推理模型在多数基准测试中表现得更为出色,然而在这场实时游戏中,它们却遭遇了挫折。原因在于,它们需要数秒钟的时间来做出决策。

在《超级马力欧兄弟》这款游戏中,时间把握至关重要,稍纵即逝的一秒差异,可能导致结果截然不同。非推理模型因其反应迅速,能捕捉到游戏中稍纵即逝的机遇,因此在游戏中表现更为出色。

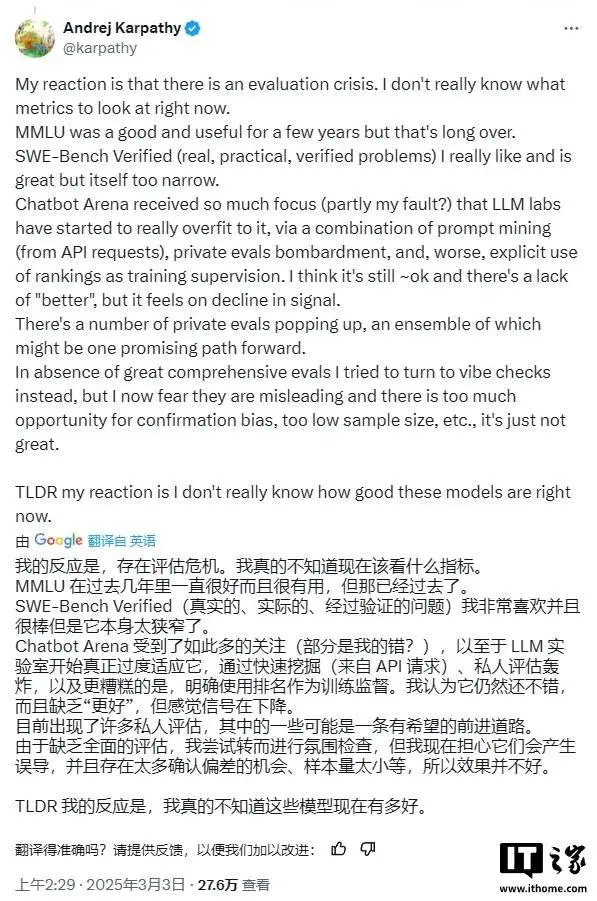

游戏测试质疑

尽管游戏在数十年的时间里一直是评估人工智能性能的关键手段,然而,一些专家对将AI在游戏中的表现直接等同于技术发展的做法表示了怀疑。相较于现实世界,游戏往往更趋于抽象和简单,同时也能为AI的训练提供大量的数据支持。

在游戏环境中,AI的表现或许不能充分展示其在真实复杂环境中的实力。即便是一些出色的游戏基准测试成绩,也引发了人们所谓的“评估困境”。

后续思考

尽管对此有不同看法,看AI操作马力欧依然挺有意思。未来研究或许能更好地结合游戏和现实环境测试,全面评估AI的表现。此外,我们还需考虑如何提升AI在多变复杂环境中的适应能力。

AI的发展之路尚且漫长,此次通过游戏进行AI测试仅是初步的探索。我们热切期待未来能有更多创新和优化,让AI在各行各业都能展现出其高效潜能。

其他推荐